คู่มือสำหรับนักข่าวในการตรวจจับเนื้อหาที่สร้างด้วย AI จาก Global Investigative Journalism Network (GIJN) แบ่งเป็น 7 หมวดหมู่ ได้แก่ ข้อผิดพลาดทางกายวิภาค การละเมิดกฎฟิสิกส์ ลายนิ้วมือทางเทคนิค สิ่งผิดปกติทางเสียง ตรรกะบริบท รูปแบบพฤติกรรม และการจดจำด้วยสัญชาตญาณ แต่ละหมวดหมู่มีวิธีตรวจสอบ 3 ระดับ คือ ด่วน 30 วินาที ละเอียด 5 นาที และเจาะลึกสำหรับข่าวสำคัญ พร้อมแนะนำเครื่องมือตรวจจับอัตโนมัติและเทคนิคการวิเคราะห์ เพื่อช่วยนักข่าวต่อสู้กับข้อมูลบิดเบือนที่สร้างด้วย AI ในยุคที่การสร้างข้อมูลเท็จใช้เวลาเพียงไม่กี่นาทีและเสียค่าใช้จ่ายไม่กี่ดอลลาร์

เรากำลังเข้าใกล้จุดที่อัตราส่วนระหว่าง "สัญญาณ" กับ "สัญญาณรบกวน" เกือบจะเท่ากันแล้ว หมายความว่า เมื่อความเร็วของข้อมูลบิดเบือนใกล้เคียงกับข้อมูลจริง มันเกือบจะเป็นไปไม่ได้เลยที่จะบอกได้ว่าอะไรคือความจริง คู่มือนี้สอนนักข่าววิธีพยายามระบุเนื้อหาที่สร้างด้วย AI ภายใต้แรงกดดันของเดดไลน์งาน โดยนำเสนอหมวดหมู่การตรวจจับขั้นสูง 7 ประการที่นักข่าวทุกคนต้องรู้ไว้

ในฐานะคนที่ช่วยกองบรรณาธิการข่าวต่อสู้กับข้อมูลบิดเบือน นี่คือสิ่งที่ทำให้นอนไม่หลับ การตรวจสอบข้อเท็จจริงแบบดั้งเดิมใช้เวลาหลายชั่วโมงหรือหลายวัน แต่การสร้างข้อมูลบิดเบือนด้วย AI ใช้เวลาแค่ไม่กี่นาที

ข้อมูลวิดีโอบิดเบือนเก่าแก่มากจนมีมาก่อนเทคโนโลยี AI สมัยใหม่หลายสิบปี แม้จะมีข้อจำกัดทางเทคนิคพื้นฐานของอุปกรณ์บันทึกยุคแรก มันก็สามารถสร้างความเข้าใจผิดที่ร้ายแรงได้ ในปี 2003 พี่เลี้ยงเด็กชื่อคลอเดีย มูโร (Claudia Muro) ต้องติดคุก 29 เดือน เพราะกล้องวงจรปิดที่มีเฟรมเรตต่ำทำให้การเคลื่อนไหวที่อ่อนโยนดูรุนแรง และไม่มีใครคิดที่จะตรวจสอบความถูกต้องของภาพ ในเดือนมกราคม 2025 ครูชาวอังกฤษชื่อเชอริล เบนเน็ตต์ (Cheryl Bennett) ต้องอยู่อย่างหลบๆ ซ่อนๆ หลังจากวิดีโอดีพเฟคแสดงเธออย่างเท็จว่ากล่าวคำพูดเหยียดเชื้อชาติ

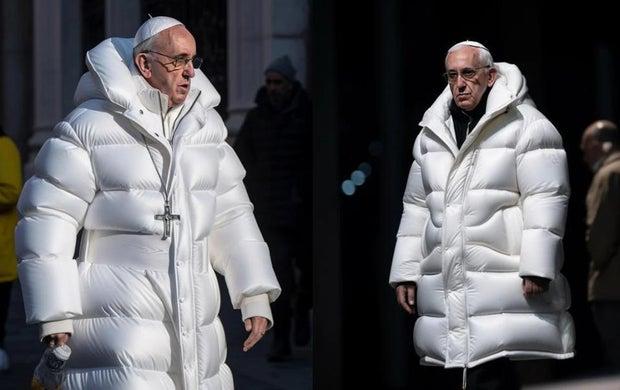

ภาพที่สร้างด้วย AI อ้างว่าแสดงสมเด็จพระสันตะปาปาฟรานซิสที่ 1 สวมแจ็คเก็ตพองของ Balenciaga ที่สร้างโดย Midjourney

ภาพไวรัลของสมเด็จพระสันตะปาปาฟรานซิสที่ 1 สวมเสื้อโค้ทพองสีขาวของ Balenciaga หลอกผู้คนนับล้านบนโซเชียลมีเดีย ก่อนจะถูกเปิดเผยว่าสร้างด้วย AI โดยใช้คำสั่งแปลงข้อความเป็นภาพของ Midjourney เบาะแสสำคัญในการตรวจจับรวมถึงไม้กางเขนที่ห้อยอยู่ที่หน้าอกของพระองค์ลอยอยู่อย่างไม่มีเหตุผล โดยมีเพียงเสื้อแจ็คเก็ตพองสีขาวตรงที่ควรเป็นอีกครึ่งหนึ่งของสร้อย ผู้สร้างภาพคือปาโบล ซาเวียร์ (Pablo Xavier) บอกกับ BuzzFeed News ว่า เขาแค่คิดว่ามันตลกดีที่เห็นสมเด็จพระสันตะปาปาสวมแจ็คเก็ตตลกๆ

บางครั้งภาพปลอมแปลงที่มีประสิทธิภาพที่สุดไม่ต้องใช้ AI เลย ในเดือนพฤษภาคม 2019 วิดีโอของแนนซี เพโลซี (Nancy Pelosi) ประธานสภาผู้แทนราษฎร ถูกชะลอความเร็วลงเหลือ 75% และปรับระดับเสียงเพื่อให้เธอดูเมาสุรา ในเดือนพฤศจิกายน 2018 ทำเนียบขาวแชร์วิดีโอที่เร่งความเร็วของการปะทะกันระหว่างจิม อาโคสตา (Jim Acosta) ผู้สื่อข่าว CNN กับเจ้าหน้าที่ฝึกงานทำเนียบขาว ทำให้การเคลื่อนไหวของแขนเขาดูก้าวร้าวกว่าความเป็นจริง

เมื่อไม่นานมานี้ มีการสร้างเรื่องอื้อฉาวทางการเมืองปลอมทั้งหมด ครบทั้งผู้ประกาศข่าว ประชาชนที่โกรธแค้น ภาพการประท้วง และตัวนายกเทศมนตรีสมมติเอง ใช้เวลาเพียง 28 นาทีระหว่างพักกลางวัน ค่าใช้จ่ายทั้งหมดเท่าไหร่ 8 ดอลลาร์ 28 นาที หนึ่งวิกฤตการเมืองที่สร้างขึ้นมาทั้งหมดซึ่งสามารถหลอกบรรณาธิการที่วุ่นวายภายใต้แรงกดดันของเดดไลน์ได้

ไม่นานมานี้ ผู้ตรวจสอบข้อเท็จจริงที่มีประสบการณ์ประกาศอย่างมั่นใจว่าภาพที่สร้างด้วย AI เป็นของจริง เพราะมันแสดงมือ 5 นิ้วที่สมบูรณ์แบบแทนที่จะเป็น 6 นิ้ว แต่ตอนนี้วิธีการนั้นแทบที่จะหมดไปแล้ว

นี่คือความจริงที่โหดร้ายของการตรวจจับ AI วิธีการที่ทำให้เรารู้สึกปลอดภัยกำลังหายไปต่อหน้าต่อตาเรา ในช่วงต้นของการพัฒนาเครื่องมือสร้างภาพ AI การวาดมือที่ไม่ดี เช่น นิ้วเกินหรือนิ้วติดกัน เป็นเรื่องธรรมดาและมักถูกใช้เพื่อจับภาพที่สร้างด้วย AI ภาพปลอมไวรัลอย่างภาพการจับกุมทรัมป์จากปี 2023 ถูกเปิดเผยบางส่วนจากข้อผิดพลาดของมือที่เห็นได้ชัด อย่างไรก็ตาม ในปี 2025 โมเดล AI รายใหญ่อย่าง Midjourney และ DALL-E ได้ปรับปรุงการสร้างมือที่ถูกต้องตามกายวิภาคอย่างมาก ผลที่ตามมาคือมือไม่ใช่วิธีที่เชื่อถือได้อีกต่อไปในการตรวจจับภาพที่สร้างด้วย AI และผู้ที่ต้องการระบุงานศิลปะ AI ต้องมองหาสัญญาณอื่นที่ละเอียดกว่าเพื่อจับภาพที่สร้างด้วย AI

การปฏิวัติการแสดงผลข้อความเกิดขึ้นเร็วยิ่งกว่า ในช่วงที่ป้ายประท้วง AI แสดงข้อความที่ยุ่งเหยิงอย่าง STTPO THE MADNESSS และ FREEE PALESTIME โมเดลปัจจุบันบางตัวสามารถสร้างตัวอักษรที่สมบูรณ์แบบ OpenAI ฝึก DALL-E 3 โดยเฉพาะเรื่องความแม่นยำของข้อความ ขณะที่ Midjourney V6 เพิ่มข้อความที่แม่นยำเป็นฟีเจอร์ที่ขายได้ สิ่งที่เคยเป็นวิธีตรวจจับที่เชื่อถือได้ตอนนี้แทบไม่ได้ผลแล้ว

หูที่ไม่สมส่วน ดวงตาที่ไม่สมมาตรอย่างผิดธรรมชาติ และฟันที่ดูเหมือนทาสีซึ่งเคยทำให้แยกใบหน้า AI ออกมาได้ง่ายๆ นั้นกำลังหายไป ภาพบุคคล AI ที่สร้างในเดือนมกราคม 2023 แสดงข้อผิดพลาดที่ตรวจจับได้ตลอดเวลา คำสั่งเดียวกัน ณ ปี 2025 กลับสร้างใบหน้าที่น่าเชื่อถือได้มากกว่าเดิม

นี่แสดงถึงอันตรายพื้นฐานสำหรับกองบรรณาธิการข่าว นักข่าวที่ได้รับการฝึกฝนด้วยวิธีตรวจจับในปี 2023 อาจมีความมั่นใจที่ผิดพลาด ประกาศว่าเนื้อหา AI ที่เห็นได้ชัดเป็นของจริงเพียงเพราะมันผ่านการทดสอบที่ล้าสมัย ความมั่นใจที่ผิดที่นี้เป็นสิ่งอันตรายมาก

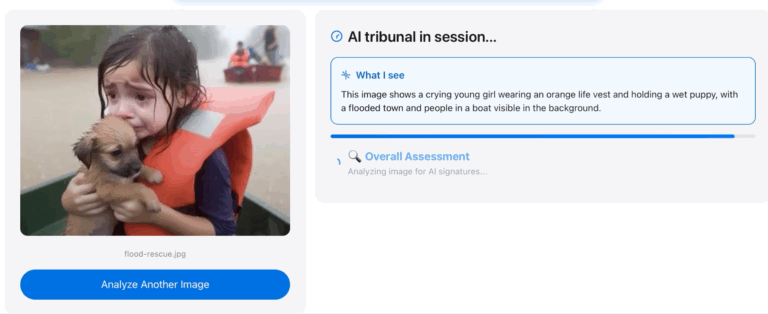

แนะนำ: Image Whisperer

การวิเคราะห์ภาพที่สร้างด้วย AI อ้างว่าแสดงเด็กหญิงถูกช่วยเหลือหลังน้ำท่วมในสหรัฐอเมริกา | ที่มาภาพ: Henk van Ess

เราารมารถสร้างโปรแกรมที่ช่วยตรวจว่าเนื้อหาไหนเป็นของ AI หรือเปล่า นักวิทยาศาสตร์พาไปดูเทคนิคที่ซับซ้อนมาก ๆ อย่างฟิสิกส์ขั้นสูง การแปลงสัญญาณ กลศาสตร์ควอนตัม และการหาลายเซ็นทางคณิตศาสตร์ที่ตาเปล่ามองไม่เห็น นักฟิสิกส์คนหนึ่งบอกว่า ความผิดพลาดของ AI ไม่ใช่แค่จุดบกพร่องในภาพธรรมดา แต่มันมีรอยนิ้วมือพิเศษที่ซ่อนอยู่ในระดับคลื่นความถี่

แต่พอมาถึงตรงนี้ ก็ได้รับคำเตือนจากผู้เชี่ยวชาญว่า "อย่าพยายามสร้างเองเลย" เพราะต้องใช้คอมพิวเตอร์ที่แรงมาก ๆ และต้องมีทีมงานที่เก่งระดับปริญญาเอกหลายคน ถ้าไม่มีทรัพยากรพวกนี้ ก็จะล้มเหลวอย่างแน่นอน

ตรงนี้แหละที่นึกออก ทำไมเราไม่ใช้ AI สู้ AI ล่ะ? แต่ใช้วิธีที่ฉลาดกว่า แทนที่จะไปสร้างระบบตรวจจับมหึมาที่ต้องเสียเงินเป็นพันล้านขึ้นมาใหม่ ก็แค่นำ AI ที่มีอยู่แล้วมาใช้ให้เป็นประโยชน์ ให้มันทำงานหนัก ๆ แทนเราดีกว่า

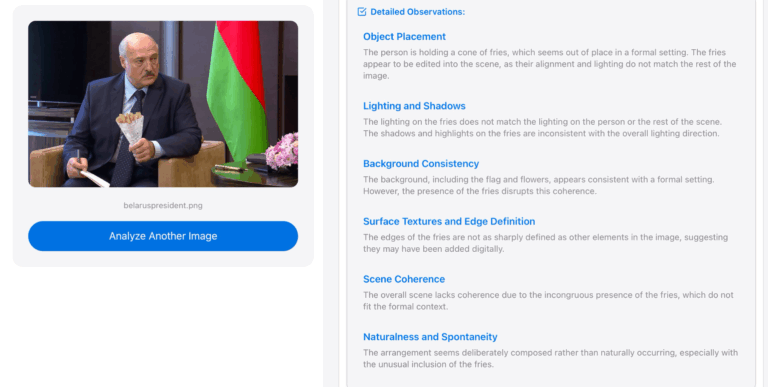

การวิเคราะห์ภาพที่สร้างด้วย AI อ้างว่าแสดงประธานาธิบดีเบลารุสถือกรวยมันฝรั่งทอด | ที่มาภาพ: Henk van Ess

Image Whisperer (ชื่อเดิมคือ Detectai.live) เกิดขึ้นจากความเข้าใจนี้ เครื่องมือนี้ทำงานการวิเคราะห์โมเดลภาษาขนาดใหญ่แบบขนานควบคู่ไปกับการประมวลผล Google Vision โดยประยุกต์ใช้หลักการฟิสิกส์ที่ผู้เชี่ยวชาญเหล่านี้สอนพร้อมใช้ประโยชน์จากพลังการประมวลผลที่มีอยู่แล้ว สิ่งสำคัญที่สุดคือแตกต่างจากเครื่องมือ AI ส่วนใหญ่ มันบอกคุณเมื่อมันไม่รู้บางอย่างแทนที่จะเดา

มันไม่ได้พยายามเป็นระบบที่ดีที่สุดในโลก แต่พยายามเป็นระบบที่ซื่อสัตย์ที่สุด

7 หมวดหมู่ของการตรวจจับ AI

การแข่งขันระหว่างผู้สร้าง AI และผู้ตรวจจับยังคงดำเนินต่อไป โดยผู้สร้างได้ประโยชน์จากความได้เปรียบด้านความเร็ว การระบุว่าอะไรเป็นหรือไม่เป็นดีพเฟคกำลังกลายเป็นเกมไล่จับระหว่างแมวกับหนูที่นักพัฒนาปรับปรุงเทคโนโลยี การระบุดีพเฟคอย่างประสบความสำเร็จต้องใช้วิธีตรวจจับหลายแบบร่วมกัน เฝ้าระวังอยู่ตลอดเวลา และยอมรับว่าการตรวจจับที่สมบูรณ์แบบอาจเป็นไปไม่ได้ สำหรับนักข่าวที่มองหาคำตอบที่แม่นยำ เป้าหมายได้เปลี่ยนจากการระบุที่แน่ชัดไปสู่การประเมินความน่าจะเป็นและการตัดสินทางบรรณาธิการอย่างรอบรู้

หมวดหมู่ที่ 1: ข้อผิดพลาดทางกายวิภาคและวัตถุ เมื่อความสมบูรณ์แบบกลายเป็นสัญญาณเตือน

การตรวจสอบด่วน 30 วินาที (สำหรับข่าวด่วน):

เมื่อเวลาเร่งด่วนและต้องตัดสินใจเร็ว ให้ใช้สัญชาตญาณว่ามีอะไรดูดีเกินจริงหรือไม่ คนในภาพดูสวยงามระดับนิตยสารไหม ทั้งที่สถานการณ์ไม่น่าจะเป็นไปได้ เช่น ผู้นำกลุ่มประท้วงแต่งหน้าเรียบร้อยไร้ที่ติ ผู้ประสบภัยมีทรงผมสวยสมบูรณ์แบบ หรือช่วงเวลาทางการเมืองที่ทุกคนดูเหมือนได้สไตลิสต์แต่ง ถ้าเจอแบบนี้ต้องสงสัยทันที

สิ่งที่ต้องดู:

1. คนนี้ดูขัดเกลาเกินไปสำหรับสถานการณ์หรือเปล่า

2. ความสวยงามระดับนิตยสารในฉากวิกฤต ดูแปลกไหม

3. ผิวเรียบเนียนแบบรีทัชมากเกินไป ทั้งที่ควรมีพื้นผิวธรรมชาติ

4. การแต่งตัวโดยรวมเข้ากับสถานการณ์จริงไหม

การตรวจสอบแบบละเอียด 5 นาที (สำหรับข่าวทั่วไป):

ดูรายละเอียดทางเทคนิคที่บ่งบอกว่าเป็นภาพสังเคราะห์ AI สมัยนี้สร้างภาพที่ถูกต้องตามร่างกาย แต่มักจะสมบูรณ์แบบจนน่าขนลุก ใบหน้าจริงมีความไม่สมมาตรเล็กน้อย มีร่องรอยการใช้งาน มีผลจากสภาพแวดล้อม ซึ่ง AI จำลองได้ยาก

วิธีตรวจ:

1. ซูมดูใบหน้า 100% หารูขุมขน พื้นผิวผิวหนังจริง ความไม่สมมาตรเล็กน้อย

2. ดูธรรมชาติของเสื้อผ้า มีรอยยับธรรมชาติไหม ผ้ามีพื้นผิว มีร่องรอยการใช้งานไหม

3. ดูเส้นผม เห็นเป็นเส้นๆ หรือดูเหมือนวาดขึ้นมา

4. ดูเครื่องประดับ มีมิติหรือแบนราบแบบกราฟิก

5. ดูฟัน มีความไม่สมบูรณ์แบบตามธรรมชาติไหม หรือสมบูรณ์แบบเหมือนกันหมดทุกซี่

6. ประเมินภาพรวม ความเรียบร้อยเข้ากับบริบทที่บอกมาไหม

การสืบสวนแบบเจาะลึก (สำหรับข่าวสำคัญ):

สำหรับข่าวสำคัญมาก ต้องถือว่าภาพเป็นหลักฐานที่ต้องตรวจสอบแบบนิติวิทยาศาสตร์ เป้าหมายคือประเมินความน่าจะเป็นจากหลายมุม แม้จะไม่มีหลักฐานชัดเจน 100% แต่ก็ตัดสินได้อย่างมีเหตุผล

ขั้นตอนการตรวจสอบ:

1. หาภาพอื่นของคนเดียวกันมาเปรียบเทียบ ดูว่าปกติเขาดูแบบไหน

2. ใช้เครื่องมือมืออาชีพขยายดูระดับพิกเซล หารูปแบบทางคณิตศาสตร์ในพื้นผิวผิวหนัง

3. ค้นหาภาพอื่นในบริบทคล้ายกัน คนนี้มักดูขัดเกลาขนาดนี้จริงไหม

4. ปรึกษาผู้เชี่ยวชาญนิติวิทยาศาสตร์ดิจิทัล ให้วิเคราะห์ขั้นสูง

5. หาภาพหรือวิดีโอจากเหตุการณ์เดียวกันมาเทียบ ดูว่าสอดคล้องกันไหม

6. เปรียบเทียบกับภาพที่ตรวจสอบแล้วของคนนี้ในช่วงเวลาและบริบทใกล้เคียงกัน

หมวดหมู่ที่ 2: การละเมิดกฎฟิสิกส์เชิงเรขาคณิต เมื่อ AI ไม่สนใจกฎธรรมชาติ

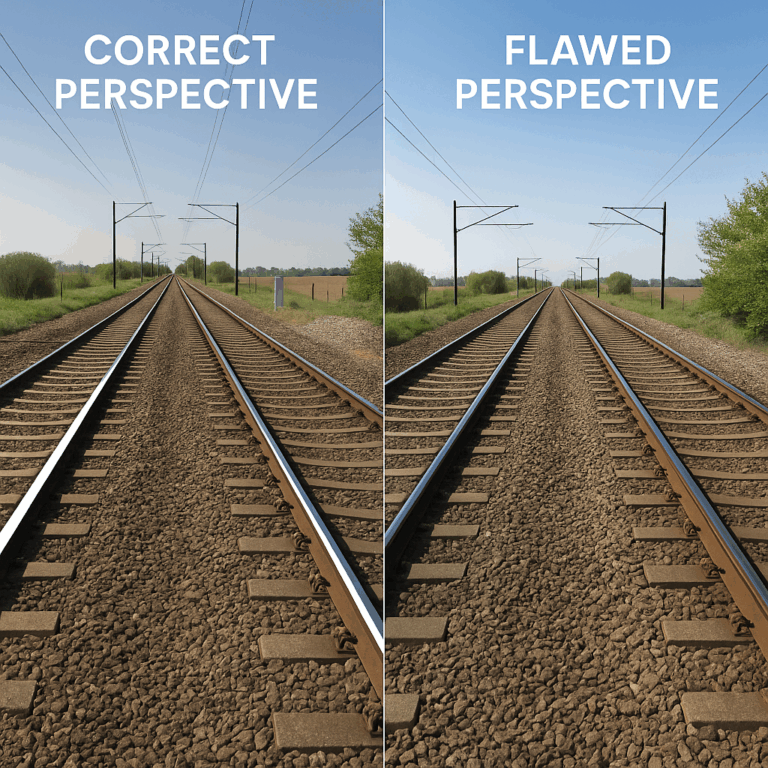

ภาพที่สร้างด้วย AI แสดงรางรถไฟทอดยาวไปไกลเทียบกับภาพมุมมองที่ถูกต้องจากชีวิตจริง | ที่มาภาพ: Henk van Ess

เรื่องราว: AI สร้างภาพแบบตัดแปะประกอบกัน ไม่ใช่ถ่ายด้วยกล้องจริง มันรู้ว่าองค์ประกอบต่างๆ ในภาพหน้าตาเป็นยังไง แต่ไม่รู้กฎเรขาคณิตและฟิสิกส์ที่ควบคุมว่าแสง มุมมอง และเงาทำงานยังไงในโลกจริง ข้อผิดพลาดเรื่องฟิสิกส์พื้นฐานพวกนี้ยากกว่าที่ AI จะแก้ เพราะมันต้องเข้าใจพื้นที่สามมิติและพฤติกรรมของแสง

ปัญหาทางฟิสิกส์ที่พบในภาพ AI: แม้เราจะยังอยู่ในยุคแรกของ AI สร้างภาพ แต่ภาพที่สร้างด้วย AI สมัยนี้ทำเงาและภาพสะท้อนได้ถูกต้องตามมุมมองแล้ว ตัวอย่างทั่วไปที่สร้างด้วย DALL-E 2 ของ OpenAI จะเห็นเงาที่ไม่สอดคล้องกัน ภาพสะท้อนที่ไม่ตรงกันอย่างเป็นไปไม่ได้หรือหายไป และเงาในภาพสะท้อนชี้ไปคนละทิศ

การวิเคราะห์จุดหายตัว: อาคารจริงเป็นไปตามกฎของมุมมอง เส้นขนานจะมาบรรจบกันที่จุดเดียวบนขอบฟ้า แต่ AI มักสร้างอาคารที่เส้นหลังคาชี้ไปทางซ้าย ขณะที่เส้นหน้าต่างชี้ไปทางขวา ซึ่งเป็นไปไม่ได้ทางกายภาพ และเปิดเผยว่ามันถูกประกอบด้วยอัลกอริทึมไม่ใช่ถ่ายจากกล้องจริง จุดหายตัวเป็นพื้นฐานของมุมมองในภาพจริง ภาพที่สร้างขึ้นมักมีเส้นต่างๆ ที่ไม่มาบรรจบกันที่จุดหายตัวที่ถูกต้อง

การตรวจสอบความสอดคล้องของเงา: ที่ไหนมีแสง ที่นั่นมีเงา ความสัมพันธ์ระหว่างวัตถุ เงาของมัน และแหล่งกำเนิดแสง เป็นเรื่องง่ายทางเรขาคณิต แต่กลับยากอย่างลวงตาที่จะทำให้ถูกต้องพอดีในภาพที่ปรับแต่งหรือสร้างขึ้นมา ในฉากที่มีแหล่งกำเนิดแสงเดียว เช่น แสงอาทิตย์ เงาทั้งหมดต้องชี้ออกจากแหล่งกำเนิดนั้น แต่ AI มักแสดงคนที่สร้างเงาหลายทิศทาง ทั้งที่มีดวงอาทิตย์ดวงเดียว ซึ่งละเมิดกฎฟิสิกส์พื้นฐาน

การยืนยันจากงานวิจัย: งานวิจัยทางวิชาการยืนยันข้อบกพร่องทางเรขาคณิตเหล่านี้ การศึกษาโดยใช้การวิเคราะห์ GradCam กับภาพกลางแจ้งพบว่ารถยนต์มีเงาชี้หลายทิศทาง และโครงสร้างบิดเบือนบริเวณจุดหายตัว ส่วนฉากในร่มพบเงาที่ไม่ตรงกับวัตถุและเส้นในห้องที่ไม่สอดคล้องกัน

การตรวจจับแบบละเอียดนี้ไม่ใช่เรื่องง่าย ต้องฝึกจ้องมองเส้นต่างๆ ให้ชินก่อน

การตรวจสอบด่วน 30 วินาที:

1. หาภาพรางรถไฟตรงๆ สักภาพ (ค้นใน Google ว่า railroad tracks perspective)

2. เปิด MS Paint หรือโปรแกรมแก้ไขภาพพื้นฐานอะไรก็ได้

3. ใช้เครื่องมือเส้นลากตามราง 2 เส้น ยืดไปทางขอบฟ้า

4. ดูว่ามันมาบรรจบกันที่จุดเดียวไหม นี่คือสิ่งที่ควรเกิดขึ้น

ตอนนี้คุณมีแม่แบบภาพว่ามุมมองที่ถูกต้องหน้าตาเป็นยังไง

การตรวจสอบแบบละเอียด 5 นาที (สำหรับข่าวทั่วไป):

ทดสอบมุมมอง:

1. เลือกอาคาร 1 หลังในภาพ

2. ใช้โปรแกรมแก้ไขภาพลากเส้นยืดตามเส้นหลังคาและแถวหน้าต่าง

3. ดูว่าเส้นจากอาคารเดียวกันมาบรรจบที่จุดเดียวไหม

4. ถ้ามีจุดหายตัวหลายจุดในโครงสร้างเดียว = ข้อผิดพลาดการประกอบของ AI

วิเคราะห์เงา:

1. หาแหล่งกำเนิดแสงหลัก จุดที่สว่างที่สุด

2. ลากเส้นจากแหล่งกำเนิดแสงผ่านยอดวัตถุไปยังปลายเงา

3. ตรวจสอบว่าเงาทั้งหมดชี้ไปทิศทางเดียวกันไหม

4. ถ้าเงาชี้คนละทิศ = ละเมิดกฎฟิสิกส์

การสืบสวนแบบเจาะลึก (สำหรับข่าวสำคัญ):

ตรวจสอบภาพสะท้อน: เมื่อวัตถุสะท้อนบนพื้นผิวเรียบ เส้นที่เชื่อมจุดบนวัตถุกับจุดที่สอดคล้องกันในภาพสะท้อนควรมาบรรจบกันที่จุดหายตัวเดียว

1. หาพื้นผิวสะท้อนในภาพ น้ำ กระจก กระจกเงา

2. ลากเส้นเชื่อมวัตถุกับภาพสะท้อนของมัน

3. ดูว่าเส้นตัดกับพื้นผิวสะท้อนเป็นมุมฉากไหม

4. ถ้าตำแหน่งภาพสะท้อนเป็นไปไม่ได้ = ความล้มเหลวทางเรขาคณิต

หมวดหมู่ที่ 3: ลายนิ้วมือทางเทคนิคและการวิเคราะห์พิกเซล ดีเอ็นเอทางคณิตศาสตร์

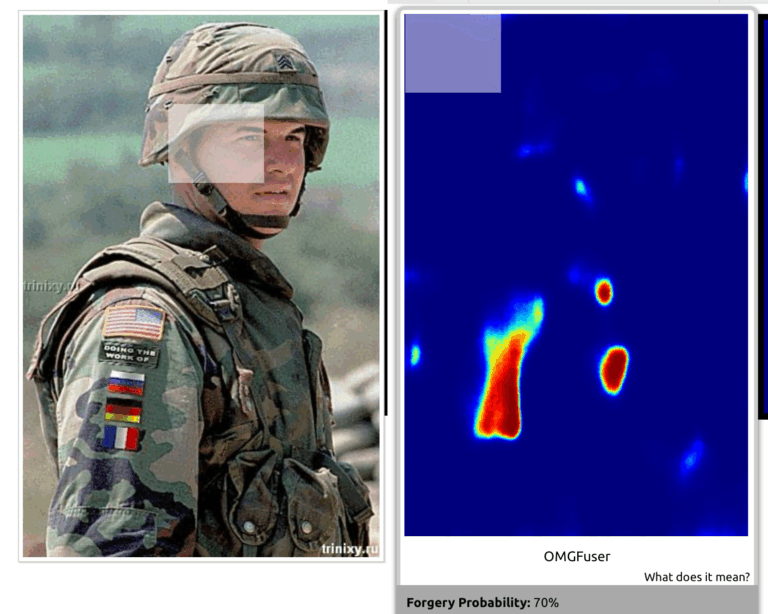

ภาพไวรัลที่ถูกแก้ไขด้วยดิจิทัลของทหารสหรัฐอเมริกาจากปี 2004 ป้าย DOING THE WORK OF พร้อมธงรัสเซีย เยอรมนี และฝรั่งเศส ถูกเพิ่มเข้ามาในภาพ เครื่องมือแสดงให้คุณเห็นพื้นที่ที่อาจถูกแก้ไขและความเป็นไปได้ที่มันถูกแก้ไข | ที่มาภาพ: Henk van Ess

เรื่องราว: เมื่อ AI สร้างภาพ มันทิ้งเบาะแสที่ซ่อนอยู่ในไฟล์ เป็นลายเซ็นทางคณิตศาสตร์เหมือนลายนิ้วมือที่มองไม่เห็นซึ่งเครื่องมือพิเศษตรวจจับได้ เบาะแสเหล่านี้อยู่ในวิธีการจัดเรียงพิกเซลและวิธีบีบอัดไฟล์ ลองคิดเหมือนหลักฐานดีเอ็นเอที่พิสูจน์ว่าอะไรบางอย่างถูกสร้างโดย AI ไม่ใช่ถ่ายจากกล้องจริง

การตรวจจับรูปแบบสัญญาณรบกวน: กล้องจริงจับภาพที่มีความไม่สมบูรณ์แบบตามธรรมชาติที่รกรุงรัง เหมือนจุดเล็กๆ สุ่มๆ จากเซ็นเซอร์กล้อง ภาพที่สร้างด้วย AI กลับมีรูปแบบที่สมบูรณ์แบบผิดธรรมชาติ เมื่อผู้เชี่ยวชาญวิเคราะห์รูปแบบเหล่านี้ด้วยซอฟต์แวร์พิเศษ พวกเขาจะเห็นรูปทรงคล้ายดาวที่ไม่มีทางปรากฏในภาพถ่ายจริง มันเหมือนความแตกต่างระหว่างสัญญาณรบกวนสุ่มจริงๆ บนทีวีเก่ากับคอมพิวเตอร์ที่พยายามปลอมความสุ่มนั้น ของปลอมมีระเบียบที่ซ่อนอยู่ซึ่งเปิดโปงตัวเอง ถ้ามีเครื่องมือที่เหมาะสม

การตรวจจับคัดลอก-วาง: เมื่อ AI หรือคนทำซ้ำบางส่วนของภาพ มันจะสร้างความสัมพันธ์ของพิกเซลที่ผิดปกติ พื้นที่ต่างกันกลายเป็นคล้ายกันอย่างน่าสงสัยเกินกว่าความซ้ำซ้อนตามธรรมชาติ ทำให้เกิดรูปแบบหรือลายเซ็นทางคณิตศาสตร์ที่ตรวจจับได้

การวิเคราะห์สิ่งผิดปกติจากการบีบอัด: เนื้อหาที่สร้างด้วย AI มักแสดงรูปแบบการบีบอัดที่ผิดธรรมชาติซึ่งแตกต่างจากไฟล์ดิบที่มาจากกล้อง เปิดเผยว่ามาจากอัลกอริทึมไม่ใช่จากเลนส์กล้อง

เครื่องมือตรวจจับมืออาชีพ: เทคโนโลยีของ TrueMedia.org สามารถวิเคราะห์สื่อที่น่าสงสัยและระบุดีปเฟกทั้งเสียง ภาพ และวิดีโอได้ ตัวอย่างดีปเฟกล่าสุดที่ TrueMedia.org จับได้ ได้แก่ ภาพที่อ้างว่าเป็นการจับกุมโดนัลด์ ทรัมป์ และภาพที่อ้างว่าเป็นประธานาธิบดีไบเดนกับเจ้าหน้าที่ทหารชั้นผู้ใหญ่

การตรวจสอบด่วน 30 วินาที:

ก่อนวิเคราะห์ภาพที่สงสัย ลองฝึกกับสิ่งที่แน่นอนก่อน:

1. อัปโหลดภาพของคุณไปที่ Image Verification Assistant

2. เทคโนโลยีจะบอกอัตราความน่าจะเป็นของการปลอมแปลง

3. ค้นคว้าภาพเพิ่มเติมเมื่อความน่าจะเป็นของการปลอมแปลงอยู่ที่ 70% ขึ้นไป

การตรวจสอบแบบละเอียด 5 นาที (สำหรับข่าวทั่วไป):

1. ตรวจสอบพื้นผิวด้วยสายตา: ซูมเข้าไป 100% ที่บริเวณอย่างผิวหนังหรือท้องฟ้า ดูพื้นผิวให้ดีๆ มันมีลักษณะสุ่มๆ ไม่เรียบร้อยแบบชีวิตจริงไหม หรือดูเรียบและสมบูรณ์แบบทางคณิตศาสตร์เกินไป ภาพถ่ายจริงมีความยุ่งเหยิงตามธรรมชาติ AI มักสร้างรูปแบบที่สม่ำเสมอจนน่าสงสัย

2. เครื่องมือตรวจจับอัตโนมัติ: อัปโหลดภาพไปที่ TrueMedia.org เว็บไซต์ฟรี เครื่องมือนี้จะรันภาพผ่านซอฟต์แวร์ตรวจจับ AI ที่วิเคราะห์ลายเซ็นทางคณิตศาสตร์ที่ซ่อนอยู่ที่เราพูดถึงก่อนหน้านี้ มันจะบอกเปอร์เซ็นต์ความเป็นไปได้ว่าภาพถูกสร้างด้วย AI

3. ตรวจสอบข้อมูลที่ซ่อนอยู่ในไฟล์: คลิกขวาที่ไฟล์ภาพและเลือก Properties บน PC หรือ Get Info บน Mac ดูที่เมทาดาทา มันจะบอกว่าซอฟต์แวร์อะไรสร้างไฟล์และเมื่อไหร่ ภาพ AI มักแสดงเวลาประทับของซอฟต์แวร์แก้ไขหรือเครื่องมือสร้างที่ไม่ตรงกับเรื่องราวที่อ้างว่าภาพถูกถ่ายเมื่อไหร่และอย่างไร

4. วิเคราะห์ความเรียบของพื้นผิว: นี่ต่างจากการตรวจสอบพื้นผิวในข้อแรก ตรงนี้คุณมองหาพื้นผิวที่ควรไม่สมบูรณ์แบบตามธรรมชาติ เช่น ผนัง ผ้า หรือน้ำ AI มักจะทำให้พื้นผิวเหล่านี้เรียบเกินไป ทั้งที่ภาพถ่ายจริงจะมีตุ่มเล็กๆ ความแตกต่างหลากหลาย หรือรอยสึกหรอ

แต่ละขั้นตอนจับข้อผิดพลาดของ AI คนละแบบ คิดเหมือนใช้การทดสอบหลายวิธีเพื่อให้แน่ใจในข้อสรุป

การสืบสวนแบบเจาะลึก (สำหรับข่าวสำคัญ):

Forensically — ชุดเครื่องมือวิเคราะห์สัญญาณรบกวนฟรีที่ครอบคลุมพร้อมการแสดงภาพโดเมนความถี่

Frequency domain analysis — การตรวจจับทางเทคนิคของรูปแบบทางคณิตศาสตร์ที่เป็นเอกลักษณ์ของ AI

หมวดหมู่ที่ 4: เสียงและสิ่งผิดปกติทางเสียง เมื่อเสียงพูดสังเคราะห์เปิดโปงตัวเอง

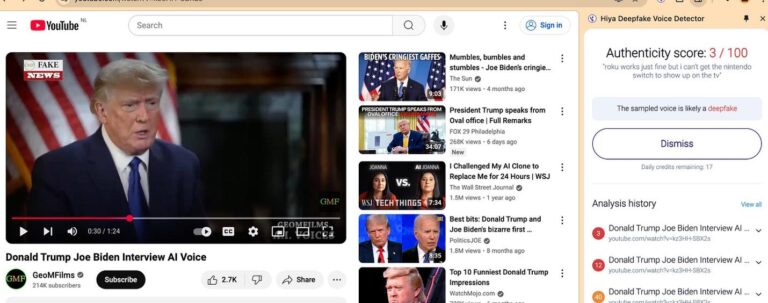

การวิเคราะห์เสียงดีพเฟคที่สร้างด้วย AI ของโดนัลด์ ทรัมป์ | ที่มาภาพ: YouTube แคปโดย Henk van Ess

เรื่องราว: เทคโนโลยีโคลนเสียงสามารถทำซ้ำเสียงของใครก็ได้จากเสียงเพียงไม่กี่วินาที แต่มันทิ้งร่องรอยที่ตรวจจับได้ของการสร้างเทียมในรูปแบบการพูด ความแท้จริงทางอารมณ์ และลักษณะเสียง แม้จะมีความแม่นยำน่าประทับใจ แต่เสียงสังเคราะห์ยังคงต่อสู้กับการจำลององค์ประกอบละเอียดอ่อนของมนุษย์ที่ทำให้คำพูดแท้จริงอย่างแท้จริง

กรณีการหลอกลวงด้วยเสียงในโลกจริง: ในเดือนมีนาคม 2019 ซีอีโอของบริษัทพลังงานในสหราชอาณาจักรได้รับโทรศัพท์จาก เจ้านาย ที่มีสำเนียงเยอรมันสมบูรณ์แบบ ขอให้โอนเงินจำนวนมาก แต่การโทรครั้งที่สองจากหมายเลขออสเตรียที่น่าสงสัยเปิดเผยการหลอกลวงด้วย AI เมื่อไม่นานมานี้ สตีเวน เครเมอร์ (Steven Kramer) ที่ปรึกษาทางการเมือง จ่าย 150 ดอลลาร์เพื่อสร้างการโทรอัตโนมัติดีพเฟค แอบอ้างเป็นประธานาธิบดีโจ ไบเดนของสหรัฐอเมริกา ซึ่งเรียกร้องให้ผู้คนไม่ลงคะแนนในการเลือกตั้งขั้นต้นของพรรคเดโมแครตในนิวแฮมป์เชียร์ปี 2024

ความเร็วและต้นทุนของเสียงปลอม: ตามคำฟ้องต่อเครเมอร์ ดีพเฟค ใช้เวลาสร้างน้อยกว่า 20 นาทีและเสียค่าใช้จ่ายเพียง 1 ดอลลาร์ เครเมอร์บอกกับ CBS News ว่าเรื่องนี้ทำให้เขาได้รับความสนใจจากสื่อคิดเป็นมูลค่าถึง 5 ล้านดอลลาร์

สัญญาณเตือนรูปแบบการพูด: ลินด์เซย์ กอร์แมน (Lindsay Gorman) ผู้ศึกษาเทคโนโลยีใหม่และข้อมูลบิดเบือน บอกกับ NBC News ว่ามักมีสัญญาณในดีพเฟค จังหวะ โดยเฉพาะตอนท้าย ดูไม่เป็นธรรมชาติ เหมือนหุ่นยนต์ นั่นเป็นหนึ่งในสัญญาณเตือนสำหรับเนื้อหาเสียงที่อาจปลอม

- จังหวะที่ไม่เป็นธรรมชาติโดยไม่มีการลังเลหรือหายใจตามปกติ

- การออกเสียงที่สมบูรณ์แบบขาดความไม่สมบูรณ์แบบของคำพูดธรรมชาติ

- น้ำเสียงแบบหุ่นยนต์ในคำหรือวลีบางคำ

- ขาดเสียงพื้นหลังจากสิ่งแวดล้อมที่ควรมีอยู่

- วลีหรือคำศัพท์ที่คนนั้นไม่มีทางใช้จริง

ความล้มเหลวของตรรกะทางภาษา: กรณีดีพเฟคก่อนหน้านี้เปิดเผย AI พูดว่า pounds 35,000 วางประเภทสกุลเงินก่อนตัวเลขในลักษณะที่ไม่เป็นธรรมชาติซึ่งเปิดเผยการสร้างสังเคราะห์

การตรวจสอบด่วน 30 วินาที:

ดูที่ Hiya Deepfake Voice Detector ปลั๊กอิน Chrome ที่เรียบง่าย ใช้ได้ 20 ครั้งต่อเดือน มันผ่านการทดสอบวิดีโอทรัมป์-ไบเดน

เป็นส่วนขยาย Chrome ที่วิเคราะห์เสียงแบบเรียลไทม์เพื่อพิจารณาว่าสิ่งที่คุณได้ยินเป็นเสียงมนุษย์จริงหรือบางอย่างที่ปรุงขึ้นโดย AI

นี่คือสิ่งที่เครื่องมือนี้ทำได้:

- วิเคราะห์เสียงในวิดีโอและเสียงที่เล่นในเบราว์เซอร์ Chrome ของคุณ

- ทำงานทันที ต้องการเสียงเพียง 1 วินาทีเพื่อตัดสินใจ

- ใช้งานได้ในเว็บไซต์ใดก็ได้ แพลตฟอร์มโซเชียลมีเดีย เว็บไซต์ข่าว แพลตฟอร์มวิดีโอ

- ตรวจจับคำพูดที่คล้ายมนุษย์ที่สร้างโดยเครื่องมือสังเคราะห์เสียง AI หลักทั้งหมด

- รองรับหลายภาษา

- ทำงานแบบเรียลไทม์ขณะที่คุณเรียกดู

ข้อควรระวัง: เนื่องจากปลั๊กอินใช้อัลกอริทึมแบบความน่าจะเป็น มันจะไม่แม่นยำ 100% ในทุกกรณี

การตรวจสอบแบบละเอียด 5 นาที (สำหรับข่าวทั่วไป):

1. ฟังความเป็นธรรมชาติของคำพูด จังหวะและการออกเสียงรู้สึกเป็นมนุษย์ไหม

2. ตรวจสอบความเป็นไปได้ คนนี้สามารถทำคำแถลงนี้ได้จริงในเวลาที่อ้างไหม

3. ตรวจสอบความแท้จริงทางอารมณ์ อารมณ์ตรงกับเนื้อหาและบริบทไหม

4. โทรกลับไปที่หมายเลขอย่างเป็นทางการเพื่อยืนยันคำขอเสียงที่เร่งด่วน

5. ถามคำถามตามบริบทที่เฉพาะคนจริงเท่านั้นที่จะรู้

การสืบสวนแบบเจาะลึก (สำหรับข่าวสำคัญ):

- ดาวน์โหลดไฟล์เสียงเต็ม

- ป้อนให้ Notta.ai และให้มันเขียนคำบรรยาย

- ขณะที่คุณรออยู่ ป้อน Claude ด้วยไฟล์เสียงที่ตรวจสอบแล้ว 5-6 ไฟล์ของคนเดียวกันหรือคำบรรยาย

- ขอให้มันทำการวิเคราะห์ความหมายและจัดหมวดหมู่ธีม รูปแบบการพูด การใช้ไวยากรณ์ สไตล์ โทนเสียง

- จากนั้นอัพโหลดคำบรรยายของเสียงที่คุณไม่ไว้ใจและขอให้ Claude เปรียบเทียบหาความผิดปกติ

หมวดหมู่ที่ 5: ตรรกะทางเวลาและบริบท เมื่อ AI มองไม่เห็นภาพใหญ่

ภาพที่สร้างด้วย AI อ้างว่าแสดงภาพนิ่งจากรายการข่าวเกี่ยวกับการประท้วงด้านสภาพภูมิอากาศในปารีส | ที่มาภาพ: Henk van Ess

เรื่องราว: AI สร้างเนื้อหาจากรูปแบบภาพโดยไม่เข้าใจบริบทในโลกจริง ตรรกะเชิงเวลา หรือความเหมาะสมของสถานการณ์ สิ่งนี้สร้างเนื้อหาที่ดูน่าเชื่อถือเมื่อดูแยกออกมา แต่พังทลายเมื่อตรวจสอบด้วยเหตุผล

การหลอกลวงด้วยวิดีโอเรือนจำอิหร่าน: วิดีโอที่สร้างด้วย AI อย่างซับซ้อนอ้างว่า แสดงการโจมตีด้วยขีปนาวุธของอิสราเอลที่เรือนจำ Evin ของอิหร่าน แต่จริงๆ แล้วถูกสร้างขึ้นจากภาพถ่ายปี 2023 จับได้จากหลายจุด หนึ่งคือฤดูกาลไม่ตรงกัน วิดีโอบอกว่าถ่ายช่วงฤดูร้อนแต่พุ่มไม้ในภาพไม่มีใบ สองคือรายละเอียดต่างๆ ตรงกับภาพเดิมสมบูรณ์แบบเกินไปจนไม่น่าจะเป็นไปได้ และสามคือเวลาที่บอกมาเป็นไปไม่ได้

การตรวจสอบด่วน 30 วินาที: AI สร้างเนื้อหาที่ดูน่าเชื่อได้ แต่มักพลาดเรื่องพื้นฐาน เช่น เวลา สถานที่ และสถานการณ์ไม่เข้ากัน เวลาเจอข่าวด่วน ให้ใช้สามัญสำนึกและความรู้ทั่วไปจับจุดที่มันดูแปลกๆ ไม่สมเหตุสมผล ซึ่งถ้าจะยืนยันให้แน่ชัดต้องใช้เวลาวิเคราะห์อีกทีหลัง

1. ตรวจสอบความสมเหตุสมผลของฤดูกาล/สภาพอากาศ พืชพันธุ์ เสื้อผ้า หรือแสงตรงกับวันที่และสถานที่ที่อ้างไหม

2. สแกนไทม์ไลน์เทคโนโลยี มีอุปกรณ์ ยานพาหนะ หรือโครงสร้างพื้นฐานที่ไม่เข้ากับช่วงเวลานี้ไหม

3. ตรวจสอบภูมิศาสตร์ด้วยสัญชาตญาณ สถาปัตยกรรม ป้าย และภูมิทัศน์ตรงกับสถานที่ที่อ้างไหม

4. ประเมินความน่าเชื่อถือของแหล่งที่มาอย่างรวดเร็ว ที่มาของเนื้อหาสอดคล้องกับความซับซ้อนและความต้องการในการเข้าถึงไหม

การตรวจสอบแบบละเอียด 5 นาที (สำหรับข่าวทั่วไป): การตรวจสอบแบบนี้ใช้ทักษะการค้นคว้าของคุณเทียบข้อมูลกับความจริงที่หาได้ AI มีปัญหาตรงที่มันไม่เข้าใจว่าเหตุการณ์ต่างๆ ในโลกจริงเชื่อมโยงกันยังไง มันสร้างภาพที่ดูผ่านได้ แต่พอเอาไปเทียบกับข้อมูลจริงภายนอก มันก็ไม่สมเหตุสมผล

1. ยืนยันสภาพอากาศในอดีต ตรวจสอบข้อมูลสภาพอากาศที่เก็บไว้สำหรับวันที่/สถานที่ที่อ้างเทียบกับสภาพที่มองเห็น

2. อ้างอิงสถานที่สำคัญทางสถาปัตยกรรม ยืนยันว่าอาคาร ป้าย และโครงสร้างพื้นฐานที่มองเห็นมีอยู่จริงที่สถานที่ที่อ้าง

3. ตรวจสอบองค์ประกอบทางวัฒนธรรม ยืนยันว่าสไตล์เสื้อผ้า พฤติกรรม และพลวัตทางสังคมตรงกับบริบททางภูมิศาสตร์/วัฒนธรรม

4. ประเมินความน่าจะเป็นของไทม์ไลน์ ค้นคว้าว่าเหตุการณ์ที่อ้างสามารถเกิดขึ้นพร้อมกันตามตรรกะได้หรือไม่

5. วิเคราะห์รูปแบบแหล่งที่มา ทำแผนที่ว่าเนื้อหาแพร่กระจายอย่างไรเมื่อเทียบกับรูปแบบการแพร่กระจายทั่วไปสำหรับเหตุการณ์ที่คล้ายกัน

6. ค้นหาหลายมุม มองหาเอกสารอื่นของเหตุการณ์เดียวกันจากแหล่งอิสระ

การสืบสวนแบบเจาะลึก (สำหรับข่าวสำคัญ): สำหรับข่าวสำคัญ ให้มองเบาะแสต่างๆ เหมือนชิ้นส่วนปริศนาที่ต้องตรวจสอบอย่างเป็นระบบเทียบกับข้อเท็จจริง วิธีนี้ไม่ได้อาศัยหลักฐานชัดเจนอันเดียว แต่รวมจุดที่ไม่สมเหตุสมผลหลายๆ จุดมาประเมินความน่าจะเป็นว่าของจริงหรือปลอม

1. สร้างไทม์ไลน์ใหม่อย่างครอบคลุม สร้างลำดับเวลาโดยละเอียดของเหตุการณ์ที่อ้างและอ้างอิงองค์ประกอบภาพทั้งหมด

2. ยืนยันข่าวกรองทางภูมิศาสตร์ ใช้ภาพถ่ายดาวเทียม Street View และความเชี่ยวชาญท้องถิ่นเพื่อยืนยันรายละเอียดสถานที่

3. นิติวิทยาศาสตร์ฤดูกาล/สิ่งแวดล้อม ปรึกษาผู้เชี่ยวชาญด้านพฤกษศาสตร์ นักอุตุนิยมวิทยา และแหล่งข้อมูลท้องถิ่นเกี่ยวกับสภาพแวดล้อม

4. ประเมินความแท้จริงทางวัฒนธรรม สัมภาษณ์ผู้เชี่ยวชาญในภูมิภาคเกี่ยวกับบรรทัดฐานพฤติกรรม รหัสการแต่งกาย และประเพณีทางสังคมที่มองเห็นในเนื้อหา

5. วิเคราะห์สิ่งที่ไม่ตรงยุคสมัยของเทคโนโลยี ยืนยันว่าอุปกรณ์ ยานพาหนะ โครงสร้างพื้นฐานที่มองเห็นทั้งหมดมีอยู่ในเวลาและสถานที่ที่อ้าง

6. ติดตามแหล่งที่มา ดูว่าเนื้อหานี้แพร่กระจายมาจากไหนและอย่างไร แล้วเทียบกับรูปแบบการแพร่ของข่าวจริงในเหตุการณ์คล้ายๆ กัน

7. เครือข่ายปรึกษาผู้เชี่ยวชาญ ติดต่อนักข่าวท้องถิ่น นักวิชาการ และเจ้าหน้าที่ที่คุ้นเคยกับสถานที่หรือสถานการณ์ที่อ้าง

8. ประเมินความน่าจะเป็นโดยรวม ให้คะแนนแต่ละจุดที่ตรวจสอบแล้วสรุปภาพใหญ่ว่าเนื้อหานี้เป็นของจริงหรือปลอม

หมวดหมู่ที่ 6: การจดจำรูปแบบพฤติกรรม เมื่อ AI เข้าใจมนุษย์ผิด

ภาพที่สร้างด้วย AI อ้างว่าแสดงผู้ประท้วงเดินขบวนบนถนนในเมือง | ที่มาภาพ: Henk van Ess

เรื่องราว: AI ทำภาพคนได้สมจริง แต่จำลองพฤติกรรมคนจริงไม่ได้ ไม่ว่าจะเป็นการมีปฏิสัมพันธ์กัน การทำตัวในสังคม หรือท่าทางธรรมชาติ ทำให้เห็นความผิดปกติในฉากที่มีคนเยอะๆ การทำตัวของกลุ่มคน และพฤติกรรมของแต่ละคน ซึ่งคนที่ผ่านการฝึกฝนจะสังเกตเห็นได้

การตรวจสอบด่วน 30 วินาที (สำหรับข่าวด่วน): AI สร้างฉากฝูงชนที่ดูจริงแวบแรก แต่พอดูดีๆ จะเห็นว่าพวกเขาทำตัวไม่เหมือนคนจริง ในสถานการณ์ข่าวด่วน ให้ดูว่าคนในภาพทำตัวเหมือนคนจริงในสถานการณ์นั้นไหม ไม่ใช่เหมือนตัวละครดิจิทัลที่ถูกโปรแกรมมา

1. ดูว่าฝูงชนดูเหมือนกันเกินไปไหม อายุพอๆ กัน หน้าตาคล้ายกัน แต่งตัวสไตล์เดียวกัน

2. ดูว่าทุกคนจ้องมองไปทางเดียวกันหรือมองกล้องหมดเลยไหม หรือมีการมองไปมาตามธรรมชาติ

3. ดูสีหน้าว่าเข้ากับอารมณ์และความรุนแรงของเหตุการณ์ไหม

4. ดูการเคลื่อนไหวว่าเป็นธรรมชาติไหม มีระยะห่างระหว่างคนที่เป็นธรรมชาติ ภาษากายดูจริง ไม่ใช่วางท่าแบบเทียม

การตรวจสอบแบบละเอียด 5 นาที (สำหรับข่าวทั่วไป): วิธีนี้ใช้ความเข้าใจของคุณเกี่ยวกับพฤติกรรมคนในสังคมเพื่อหาจุดอ่อนของ AI ฝูงชนจริงมีรูปแบบทางสังคมที่ซับซ้อนซึ่ง AI เรียนรู้ไม่ทัน ทำให้ฝูงชนที่ควรจะเกิดขึ้นเองตามธรรมชาติกลับดูเหมือนกันหมดอย่างผิดปกติ

1. ตรวจสอบความหลากหลายของคน นับดูว่ามีคนหลายช่วงอายุไหม แต่งตัวหลายสไตล์ไหม มีหลายเชื้อชาติไหม หรือดูเหมือนกันหมด

2. ดูการมีปฏิสัมพันธ์กัน มีคนคุยกันจริงๆ ไหม มีความสัมพันธ์กัน มีกลุ่มก้อนตามธรรมชาติ หรือดูเหมือนวางท่า

3. ดูว่าคนตอบสนองกับสภาพแวดล้อมถูกต้องไหม เช่น อากาศ แสง เสียงดัง

4. ดูพฤติกรรมทางวัฒนธรรม บรรทัดฐานทางสังคม ระยะห่างระหว่างคน การปฏิสัมพันธ์ตรงกับสถานที่ที่อ้างไหม

5. ดูสีหน้าของแต่ละคน มีสีหน้าที่แตกต่างกันและเป็นอารมณ์จริงไหม หรือดูเหมือนกันหมดแบบทั่วไป

6. ดูการเคลื่อนไหว มีความไม่สมมาตรตามธรรมชาติและลีลาเฉพาะตัวไหม หรือเคลื่อนไหวเรียบเกินไปแบบเทียม

การสืบสวนแบบเจาะลึก (สำหรับข่าวสำคัญ): สำหรับข่าวสำคัญ ให้มองพฤติกรรมของคนเหมือนหลักฐานทางมานุษยวิทยาที่ต้องวิเคราะห์รูปแบบทางสังคมอย่างเป็นระบบ วิธีนี้ตรวจสอบว่าการปฏิสัมพันธ์ที่ซับซ้อนของมนุษย์จะเกิดขึ้นได้จริงในสถานการณ์ที่อ้างหรือไม่

1. วิเคราะห์ฝูงชนแบบสังคมวิทยา ปรึกษาผู้เชี่ยวชาญจิตวิทยาฝูงชนเพื่อยืนยันว่าพลวัตของกลุ่มสมจริงสำหรับประเภทเหตุการณ์ที่อ้าง

2. ยืนยันความแท้จริงทางวัฒนธรรม สัมภาษณ์ผู้เชี่ยวชาญในภูมิภาคเกี่ยวกับพฤติกรรมทางสังคมที่เหมาะสม การแต่งกาย รูปแบบการปฏิสัมพันธ์

3. ประเมินความน่าจะเป็นทางประชากร ค้นคว้าว่าองค์ประกอบของฝูงชนตรงกับรูปแบบผู้เข้าร่วมทั่วไปในเหตุการณ์คล้ายกันไหม

4. ตรวจสอบพฤติกรรมของแต่ละคน วิเคราะห์คนเฉพาะเพื่อดูว่ามีบุคลิกที่สอดคล้องกัน มีความสัมพันธ์กัน มีการแสดงอารมณ์ที่แท้จริง

5. ศึกษาการปรับตัวกับสิ่งแวดล้อม ยืนยันว่าฝูงชนตอบสนองกับสภาพอากาศ เสียง และสถานที่ตรงกับความเป็นจริง

6. ค้นคว้าเปรียบเทียบในอดีต เปรียบเทียบกับภาพถ่ายหรือวิดีโอที่ยืนยันแล้วจากเหตุการณ์จริงที่คล้ายกันในภูมิภาคหรือบริบททางวัฒนธรรมเดียวกัน

7. ปรึกษาผู้เชี่ยวชาญหลายคน ติดต่อนักมานุษยวิทยา นักสังคมวิทยา และนักข่าวท้องถิ่นที่คุ้นเคยกับพลวัตทางสังคมในภูมิภาค

8. วิเคราะห์สีหน้าเล็กๆ น้อยๆ ปรึกษาผู้เชี่ยวชาญเพื่อดูสีหน้าว่าเป็นการแสดงอารมณ์จริงหรือสร้างขึ้นเทียม

9. ทำแผนที่เครือข่ายทางสังคม ติดตามความสัมพันธ์ระหว่างแต่ละคนเพื่อยืนยันว่ากลุ่มเกิดขึ้นจริงหรือถูกประกอบขึ้นเทียม

หมวดหมู่ที่ 7: การจดจำรูปแบบด้วยสัญชาตญาณ ระบบตรวจจับโบราณ

ภาพที่สร้างด้วย AI อ้างว่าประธานาธิบดีเบลารุสกำลังถือกรวยมันฝรั่งทอดในการประชุมทางการ ซึ่งดูแปลกและไม่เข้าเรื่อง | ที่มาภาพ: Henk van Ess

เรื่องราว: สมองของเรามีวิวัฒนาการในการจดจำรูปแบบมาหลายล้านปี ส่วนรูปแบบของ AI มาจากข้อมูลฝึกฝนและกระบวนการอัลกอริทึม เมื่อมีบางอย่างผิดไปจากความคาดหวังตามธรรมชาติที่ฝังอยู่ในการรับรู้ของมนุษย์ ความรู้สึกสัญชาตญาณนั้นมักเป็นเครื่องมือตรวจจับเบื้องต้นที่เร็วและเชื่อถือได้ที่สุดก่อนจะทำการวิเคราะห์ทางเทคนิค

เรื่องราวความสำเร็จในโลกจริง: ในปี 2019 ผู้ใช้โซเชียลมีเดียตั้งคำถามทันทีกับภาพไวรัล ฉลามบนถนน ระหว่างพายุเฮอริเคนฟลอเรนซ์ แม้ภาพจะดูเทคนิคดี แต่คนดูรู้สึกว่ามันแปลกสำหรับสถานการณ์นั้น สัญชาตญาณของพวกเขาถูกต้อง เมื่อค้นหาย้อนกลับพบว่าถูกใส่เข้าไปด้วยดิจิทัล ในทำนองเดียวกัน นักข่าวที่มีประสบการณ์สามารถรู้สึกได้เมื่อภาพสมัครเล่นดูเหมือนภาพยนตร์มากเกินไป หรือเมื่อมีเอกสารบันทึกที่สมบูรณ์แบบสำหรับเหตุการณ์ที่ควรเกิดขึ้นเองตามธรรมชาติ

ข้อเท็จจริงสนุกๆ: ดูเหมือนว่าการพบเจอที่ถูกอ้างเกิดขึ้นมานานกว่าทศวรรษในหลายพายุเฮอริเคน แต่มีตัวอย่างเดียวที่ได้รับการยืนยัน

การตรวจสอบด่วน 30 วินาที: เชื่อการจดจำรูปแบบจากวิวัฒนาการของคุณเมื่อเวลาจำกัด มองหาความขัดแย้งของคุณภาพการผลิต ที่แหล่งข้อมูลสมัครเล่นสร้างเนื้อหาระดับฮอลลีวูด หรือความสะดวกของเวลา ที่เหตุการณ์วุ่นวายถูกบันทึกได้อย่างสมบูรณ์แบบ ระบบตรวจจับโบราณของคุณมักจับความผิดปกติเหล่านี้ได้ก่อนที่การวิเคราะห์ทางเทคนิคจะยืนยัน

1. ปฏิกิริยาความรู้สึกแรกพบ นี่รู้สึกแท้จริงหรือดู ถูกผลิตขึ้นมา เชื่อความรู้สึกไม่สบายใจต่อภาพจำลองมนุษย์แบบเทียม หรือที่เรียกว่าความรู้สึก "uncanny valley" (ความรู้สึกขนลุกหรือไม่สบายใจ)

2. ความขัดแย้งของต้นทุนการผลิต แหล่งข้อมูลสมัครเล่นสอดคล้องกับคุณภาพระดับภาพยนตร์ไหม 8 ดอลลาร์ตอนนี้สามารถสร้างเรื่องอื้อฉาวทางการเมืองที่ดูมืออาชีพได้

3. ตรวจสอบความสะดวกของเวลา การบันทึกเหตุการณ์ที่สมบูรณ์แบบเกิดขึ้นเร็วเกินไปสำหรับการบันทึกปกติไหม

4. ทดสอบการบงการอารมณ์ เนื้อหาถูกออกแบบมาเพื่อกระตุ้นปฏิกิริยาทางอารมณ์และการแชร์อย่างรวดเร็วมากกว่าแจ้งข้อมูลให้ผู้อ่านไหม

การตรวจสอบแบบละเอียด 5 นาที (สำหรับข่าวทั่วไป): เปลี่ยนความรู้สึกสัญชาตญาณให้เป็นการตรวจสอบอย่างเป็นระบบโดยตรวจสอบองค์ประกอบเฉพาะที่กระตุ้นความสามารถในการจดจำรูปแบบของคุณ เมื่อสัญชาตญาณบอกว่ามีอะไรแปลกๆ ให้ระบุว่าอะไรที่ฝ่าฝืนความคาดหวังตามธรรมชาติเพื่อสร้างเหตุผลเชิงตรรกะ

1. ตรวจสอบตรรกะบริบทอย่างลึก สถานการณ์สมเหตุสมผลตามความรู้ในโลกจริงไหม

2. สืบสวนความน่าเชื่อถือของแหล่งที่มา แหล่งที่มาตรงกับความซับซ้อนและความต้องการในการเข้าถึงเนื้อหาไหม

3. วิเคราะห์ความสะดวกของเรื่องราว เรื่องราวสอดคล้องกับความตึงเครียดทางการเมืองหรือสังคมในปัจจุบันมากเกินไปไหม

4. ตรวจสอบความไม่สอดคล้องทางเทคนิค คุณภาพ แสง หรือเสียงตรงกับสถานการณ์ที่อ้างไหม

5. จัดทำรายการการละเมิดรูปแบบ บันทึกองค์ประกอบเฉพาะที่กระตุ้นความรู้สึกสงสัยหรือความเป็นไปไม่ได้ตามบริบท

6. ประเมินความไม่ตรงกันระหว่างแหล่งที่มาและเนื้อหา ตั้งคำถามกับเนื้อหาที่ซับซ้อนจากแหล่งข้อมูลสมัครเล่นหรือไม่ระบุชื่อที่ไม่มีคำอธิบาย

การสืบสวนแบบเจาะลึก (สำหรับข่าวสำคัญ): สำหรับข่าวสำคัญ ให้ถือว่าการตรวจจับด้วยสัญชาตญาณเป็นจุดเริ่มต้นสำหรับการตรวจสอบที่ครอบคลุม การจดจำรูปแบบของคุณระบุความผิดปกติได้ ตอนนี้ให้ตรวจสอบแต่ละองค์ประกอบที่กระตุ้นความสงสัยอย่างเป็นระบบเพื่อสร้างการประเมินที่อิงหลักฐาน

1. ตรวจสอบความรู้สึกสัญชาตญาณอย่างละเอียด จัดทำรายการทุกองค์ประกอบที่รู้สึก แปลกๆ และค้นคว้าว่าทำไมแต่ละอย่างถึงฝ่าฝืนความคาดหวังตามธรรมชาติ

2. สืบสวนความขัดแย้งของการผลิต คำนวณทรัพยากรที่ต้องการจริงเปรียบเทียบกับความสามารถที่คนสมัครเล่นควรมี

3. วิเคราะห์ความเป็นไปไม่ได้ตามบริบท เทียบสถานการณ์กับความรู้ในโลกจริงและข้อมูลเชิงลึกจากการปรึกษาผู้เชี่ยวชาญ

4. ประเมินการบงการอารมณ์ วิเคราะห์โครงสร้างเนื้อหาว่าถูกออกแบบมาให้แพร่ไวรัลหรือเป็นการแบ่งปันข้อมูลตามธรรมชาติ

5. เจาะลึกความไม่สอดคล้องทางเทคนิค วิเคราะห์คุณภาพ แสง และเสียงที่ไม่ตรงกันทีละเฟรม

6. ยืนยันความแท้จริงของแหล่งที่มา สืบสวนว่าแหล่งที่มาที่อ้างสามารถผลิตเนื้อหานี้ได้จริงไหม

7. ตรวจจับการสร้างเรื่องราว ตรวจสอบการสร้างเรื่องราวว่าเป็นความสะดวกแบบเทียมหรือการพัฒนาเหตุการณ์ตามธรรมชาติ

8. ปรึกษาผู้เชี่ยวชาญเรื่องการละเมิดรูปแบบ ให้นักสืบที่มีประสบการณ์ประเมินด้วยสัญชาตญาณอย่างอิสระ

9. วิเคราะห์เกณฑ์ความไว้วางใจ บันทึกเมื่อหลายองค์ประกอบดู แปลกๆ และให้เหตุผลในการปฏิเสธเนื้อหาแม้จะมีความสามารถทางเทคนิค

เมื่อไหร่ควรเชื่อสัญชาตญาณ:

- ถ้าหลายองค์ประกอบรู้สึก แปลกๆ แม้คุณจะระบุปัญหาเฉพาะไม่ได้

- เมื่อเนื้อหากระตุ้นปฏิกิริยาทางอารมณ์ทันที ซึ่งถูกออกแบบมาเพื่อป้องกันการวิเคราะห์

- ถ้าแหล่งที่มา เวลา หรือบริบททำให้เกิดคำถามเชิงตรรกะ

- เมื่อคุณภาพทางเทคนิคไม่ตรงกับระดับประสบการณ์ของผู้ผลิต

- ถ้าสมองของคุณตรวจจับความขัดแย้งของคุณภาพการผลิตหรือความสะดวกของเวลาที่การทดลองของคุณแสดงให้เห็น

ความจริง: ไม่มีวิธีแก้ปัญหาที่สมบูรณ์แบบ

สรุป

7 หมวดหมู่ของการตรวจจับ AI และเครื่องมือใหม่ ได้แก่ ข้อผิดพลาดทางกายวิภาค การละเมิดกฎฟิสิกส์ ลายนิ้วมือทางเทคนิค สิ่งผิดปกติทางเสียง ตรรกะบริบท รูปแบบพฤติกรรม และการจดจำด้วยสัญชาตญาณ ให้ชุดเครื่องมือที่ครอบคลุมแก่นักข่าวในการประเมินความแท้จริงของเนื้อหาภายใต้แรงกดดันของเดดไลน์ เมื่อรวมกับเครื่องมือตรวจจับมืออาชีพและมาตรฐานบรรณาธิการที่อัปเดต เราสามารถรักษาความน่าเชื่อถือได้ ใช้ไฟสู้ไฟ ใช้ AI ตรวจจับ AI และช่วยรักษาสิ่งที่เหลืออยู่ของความเป็นจริงที่เราแบ่งปันกัน

เกี่ยวกับผู้เขียน

Henk van Ess ผู้เชี่ยวชาญการใช้ AI ในงานข้อมูล เขาประยุกต์ใช้ทักษะนี้ในการสืบสวนสอบสวนและสร้างเครื่องมือสาธารณะ เช่น SearchWhisperer และ AI Researcher เขายังเป็นวิทยากรให้กับกองบรรณาธิการข่าวทั่วโลก เช่น Washington Post, Axel Springer, BBC และ DPG รวมถึงเป็นผู้บริหาร Digital Digging ซึ่งเป็นแหล่งรวมของ Open Source Intelligence และ AI นอกจากนี้ เขายังทำหน้าที่เป็นผู้ประเมินให้กับเครือข่ายตรวจสอบข้อเท็จจริงนานาชาติของ Poynter (IFCN) และเครือข่ายมาตรฐานการตรวจสอบข้อเท็จจริงแห่งยุโรป (EFCSN) ด้วย

ที่มา:

Reporter’s Guide to Detecting AI-Generated Content (Henk van Ess, GIJN, 1 September 2025)

www.facebook.com/tcijthai

ป้ายคำ